实例判别学习 - Non-Parametric Instance Discrimination精读

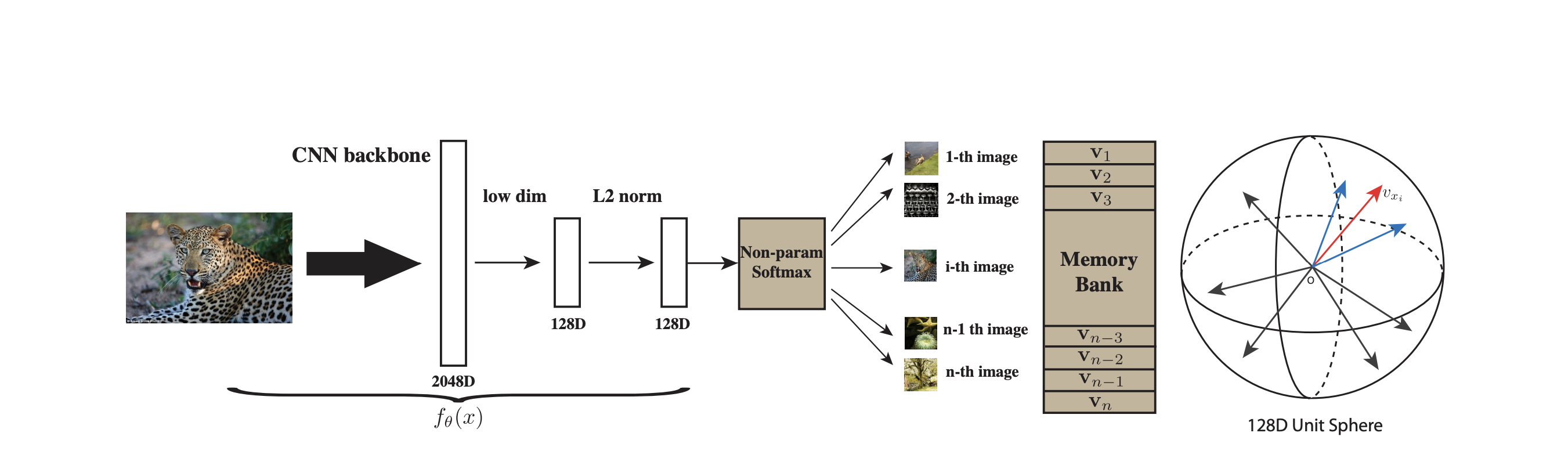

Unsupervised Feature Learning via Non-Parametric Instance Discrimination 论文地址:https://arxiv.org/pdf/1805.01978 代码地址:https://github.com/zhirongw/lemniscate.pytorch 引言 实例判别(Instance Discrimination)...

Mamba详解 - 选择性状态空间模型精读

Mamba: Linear-Time Sequence Modeling with Selective SSMs 论文地址:https://arxiv.org/pdf/2312.00752 代码地址:https://github.com/state-spaces/mamba 引言 Mamba 是一种基于状态空间模型(State Space Model, SSM)的高效序列建模框架,旨在在保持强表达能力的同时,将计算与内存复杂度降至与序列长度线性相关。与Transformer的二次复杂度相比,Mamba在超长序列、低时延和内存受限场景中具有显著优势。 Mamba的核心在于“选择性扫描(Selective Scan)”与“输入依赖的状态转移”,通过对经典S4(Structured State Space Sequence Model)的工程化与理论改进,实现端到端可训练、GPU友好、且具有SOTA性能的线性时间序列模型。 背景知识:状态空间模型(SSM)与S4 连续与离散SSM 连续时间SSM: $$ \dot x(t) = A x(t) + B u(t), \quad y(t)...

MAE详解 - Masked Autoencoders精读

Masked Autoencoders Are Scalable Vision Learners 引言 MAE (Masked Autoencoders) 由He Kaiming团队在2021年提出,为视觉自监督学习带来了新的范式。论文标题“Masked Autoencoders Are Scalable Vision Learners”凸显了其两大特性:一是基于掩码的自重构任务;二是能在大规模数据和模型上稳定扩展。和SimCLR、MoCo等对比学习方法相比,MAE丢弃了昂贵的负样本构造环节,通过简单的遮挡-重建目标即可学习高质量的视觉特征。 在图像理解任务中,过去的自监督方法往往依赖对比学习或生成式建模。MAE将NLP中成熟的Masked Language Modeling理念迁移到视觉领域,将图片切分为patch token,然后随机遮挡大部分token,让模型仅凭剩余少量可见token推断出被遮挡的像素,从而学到上下文结构。 背景知识 自监督视觉预训练的演进 预文本任务 (Pretext...

BERT详解 - 双向编码器表示模型精读

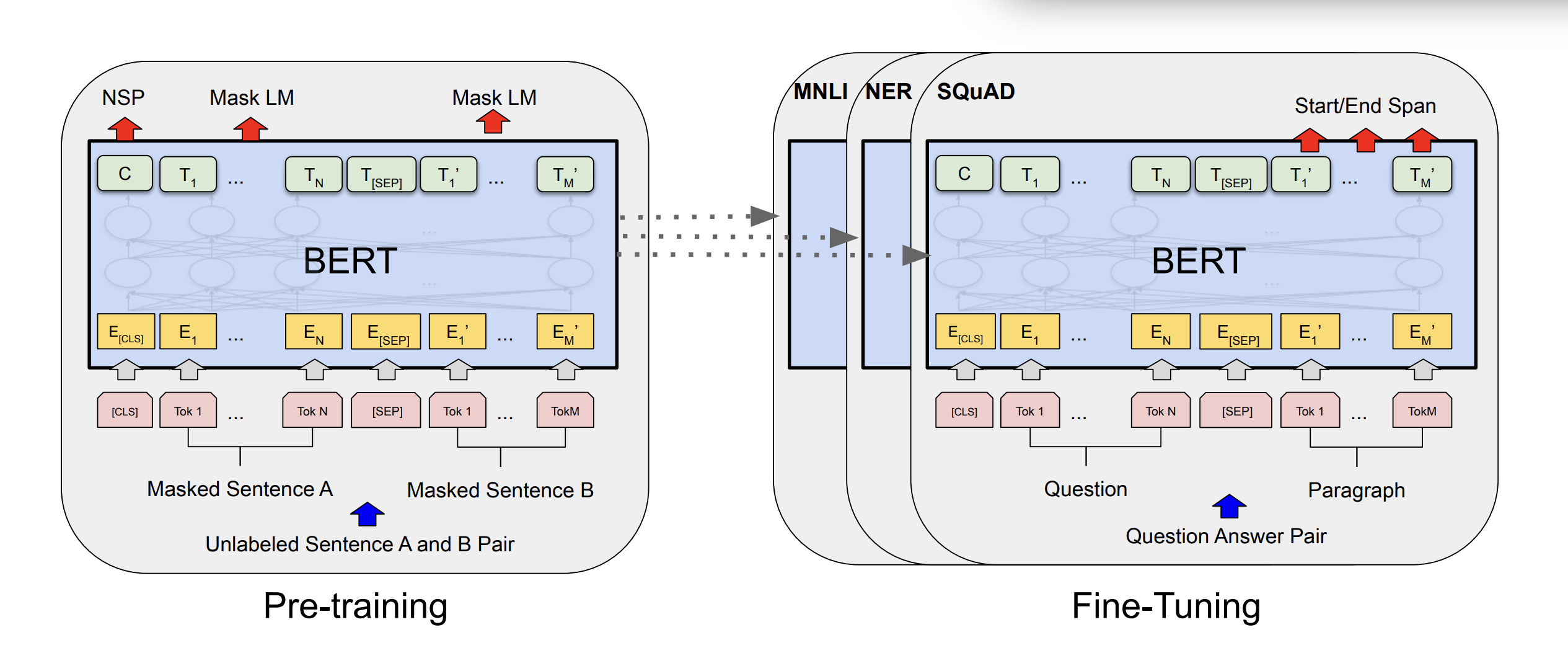

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding 引言 BERT (Bidirectional Encoder Representations from Transformers) 是Google在2018年提出的革命性自然语言处理模型,它通过在无标注文本上进行预训练,学习深层的双向语言表示,在下游任务上取得了突破性的成果。 BERT的核心创新在于双向上下文编码,与之前的ELMo(浅层双向)和GPT(单向)不同,BERT使用Transformer编码器同时利用上下文信息,彻底改变了NLP领域的预训练范式。 背景知识 预训练语言模型的发展 在BERT之前,主流的预训练方法存在以下局限性: 单向语言模型(如GPT):只能从左到右或从右到左进行编码,无法同时利用双向上下文 浅层双向模型(如ELMo):虽然考虑了双向信息,但只是简单拼接左右向表示,而非深度双向,网络架构比较老,使用的RNN 为什么需要双向编码? 语言的理解往往需要同时考虑前后文信息。例如: “银行”...

MambaOut

MambaOut MambaOut: Do We Really Need Mamba for Vision? (CVPR...

图神经网络

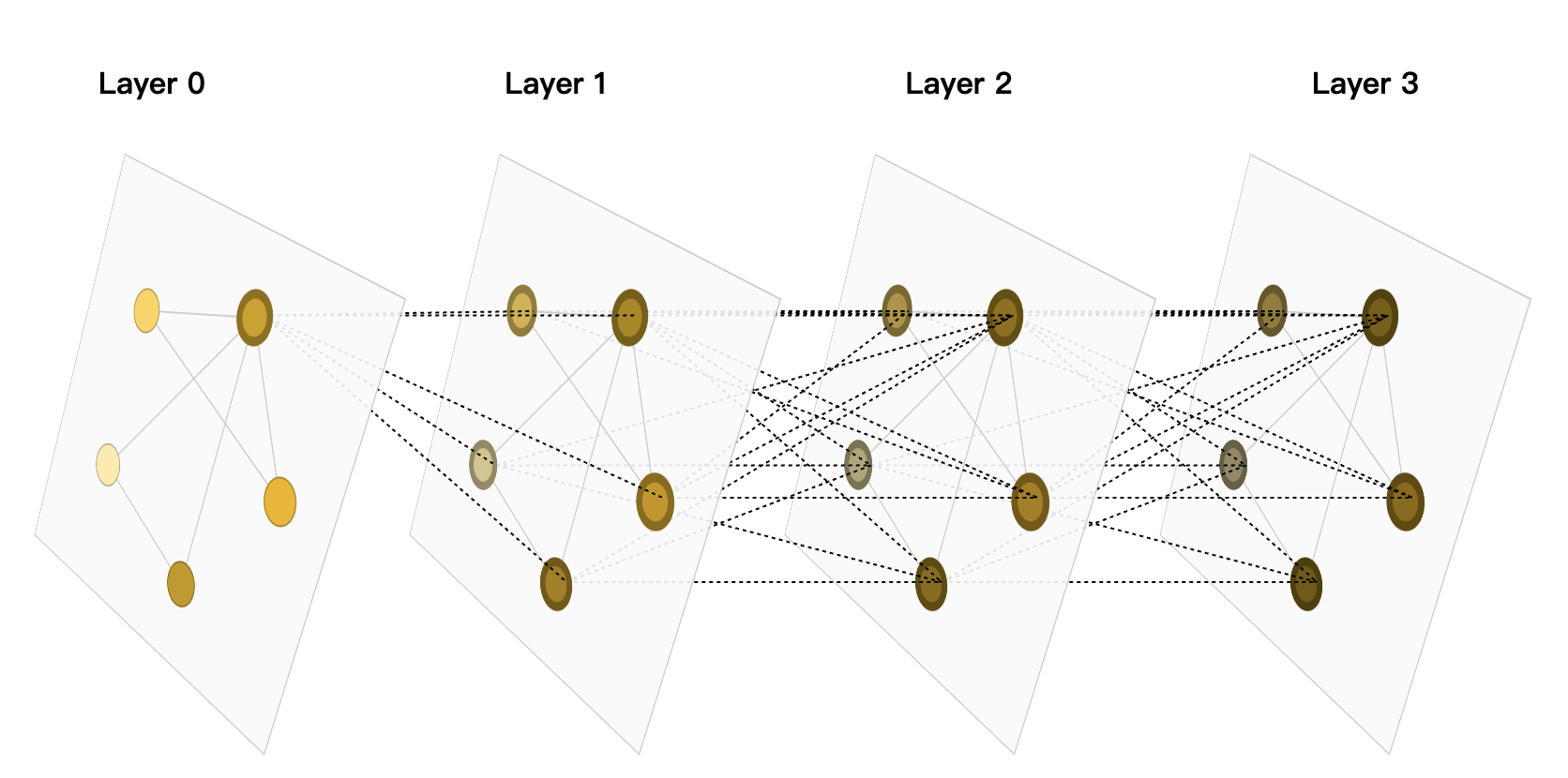

图神经网络(GNN)全面指:从基础到高级应用 引言 在数据爆炸的时代,传统深度学习模型如CNN和RNN在处理结构化数据(如图像和序列)上取得了巨大成功,但现实世界中的许多数据都具有图结构(Graph Structure),例如社交网络、分子结构、知识图谱、交通网络等。这些数据是非欧几里德的(Non-Euclidean),节点之间存在复杂的拓扑关系,无法直接用网格或序列表示。这就是图神经网络(Graph Neural Networks, GNN)登场的原因。 GNN 通过模拟节点间的消息传递机制,捕捉图的局部和全局结构,实现对图数据的表示学习。它已在推荐系统、药物发现、蛋白质折叠预测等领域大放异彩。本文将从基础概念入手,逐步深入GNN的核心原理、经典模型、实现技巧和实际应用,帮助你全面掌握这一技术。无论你是初学者还是有经验的从业者,这篇指南都能提供实用价值。 图数据基础 图的定义与表示 图 $ G = (V, E) $ 由节点集 $ V $(Vertices)和边集 $ E...

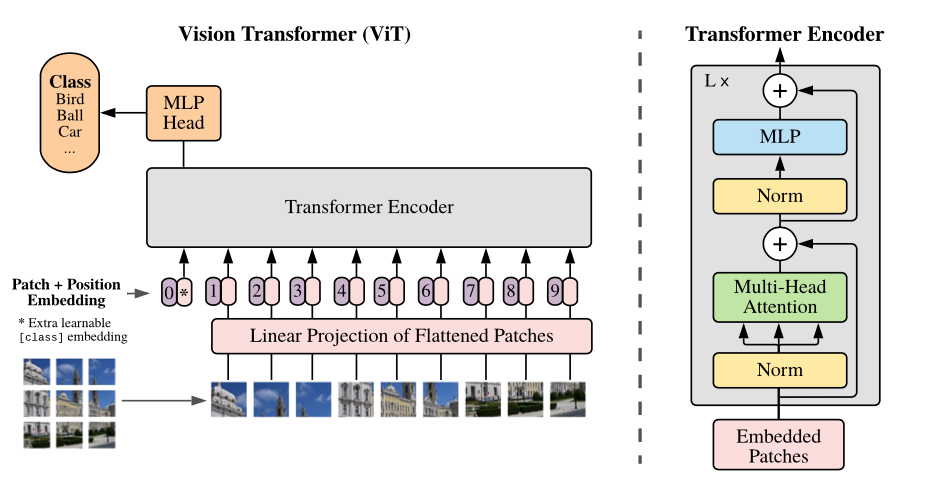

手撕 Vision Transformer

手撕 Vision...

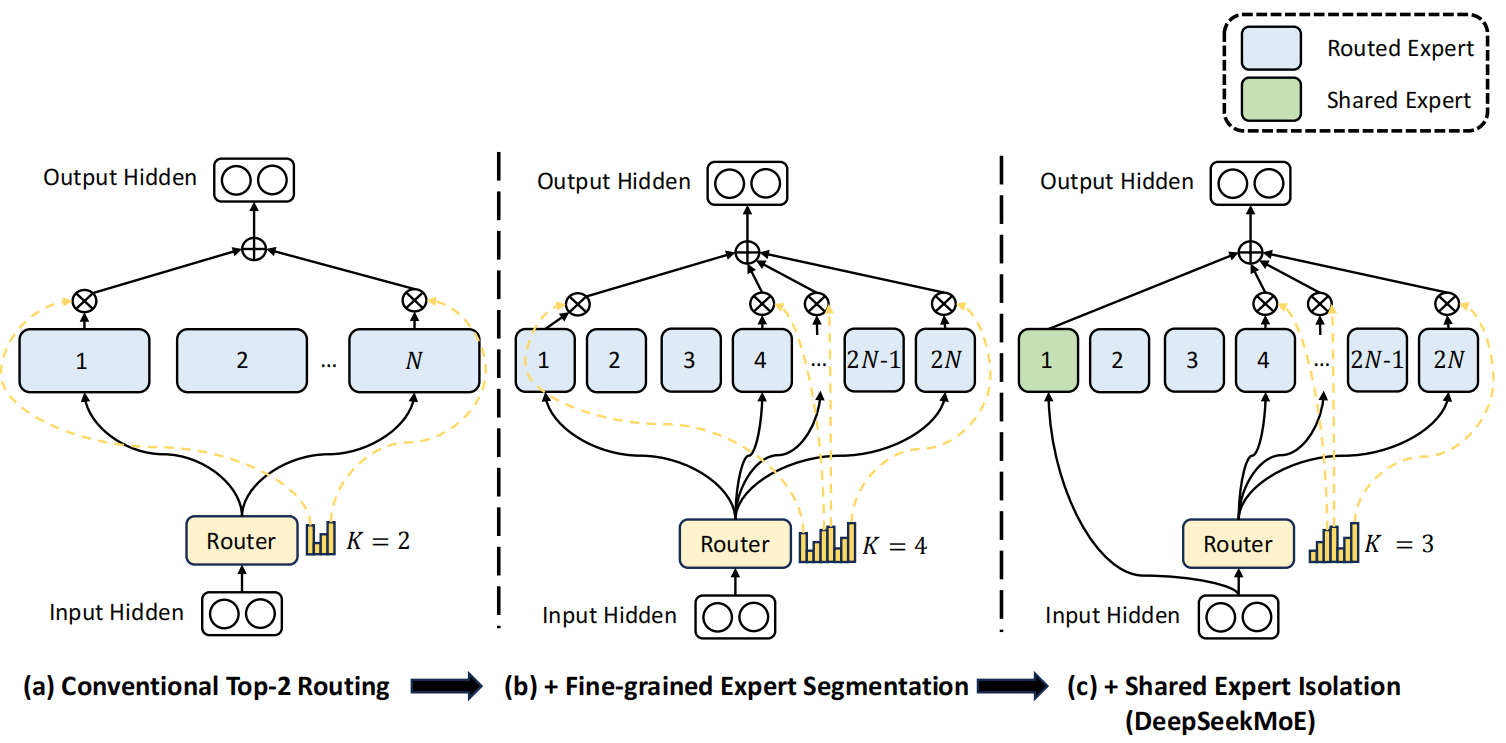

MoE

Mixtures of Experts 《Adaptive Mixture of Local Experts》 论文链接:https://www.cs.toronto.edu/~hinton/absps/jjnh91.pdf 1991年,由 Hinton和 Jordan提出,这是最早的MoE架构。 核心思想:通过多个独立专家网络处理输入数据不同子集,并由门控网络动态选择专家。每个专家接受相同的输入数据,但通过门控网络的动态分配,专家会专注于处理输入空间的特定区域。 基础架构 如图,一个由专家网络和门控网络组成的系统。每个专家是一个前馈网络,所有专家接收相同的输入,并具有相同数量的输出。门控网络也是一个前馈网络,通常接收与专家网络相同的输入。它的输出是归一化的 $ p_j = \exp(r_j) / \sum_i \exp(r_i) $,其中 $ r_j $是门控网络输出单元 $j$ 接收的总加权输入。选择器(selector)类似于一个多输入单输出的随机开关;开关选择来自专家 $ j $ 的输出的概率为 $p_j$...

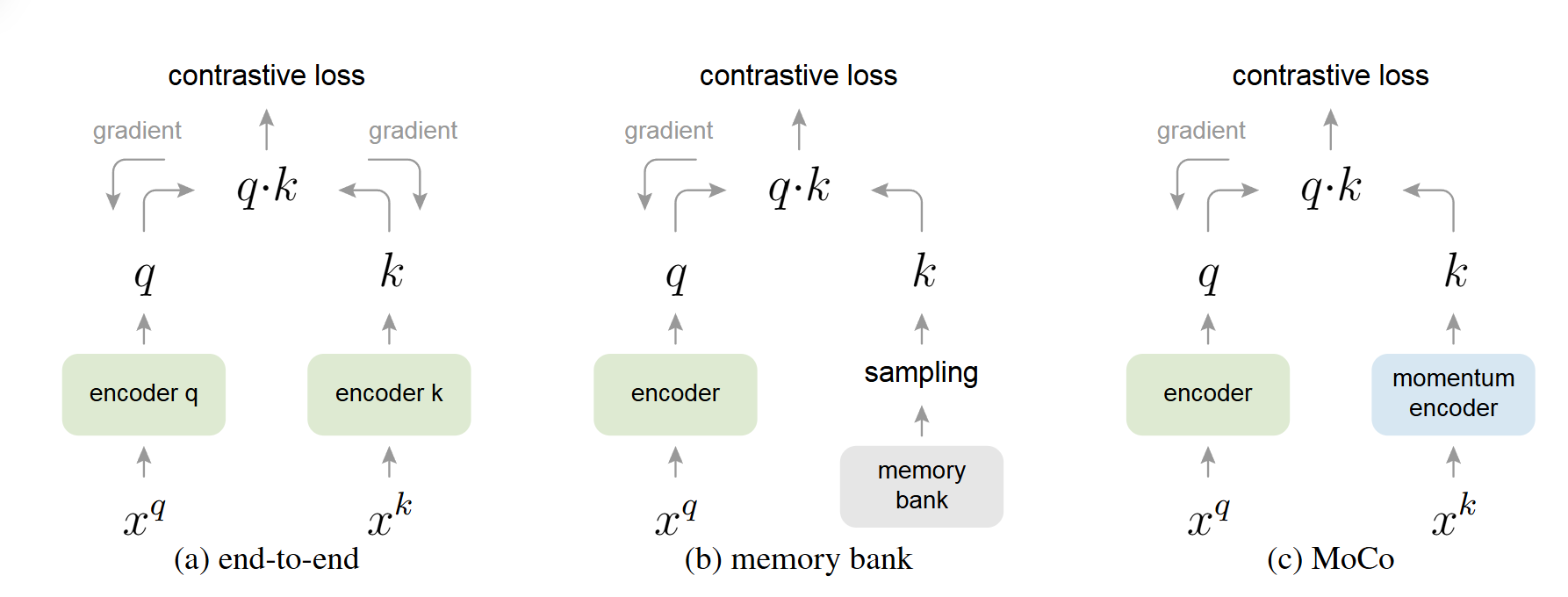

MoCo

MoCo Momentum Contrast for Unsupervised Visual Representation Learning (cvpr2020) 论文地址:https://arxiv.org/pdf/1911.05722 代码地址:https://github.com/facebookresearch/moco 概述 MoCo 将对比学习看作是一个字典查找任务 :一个编码后的查询(query)应该与其匹配的键(正样本)相似,而与其他所有的键(负样本)不相似 。 对比学习的核心思想是训练一个编码器,使其能够区分相似(正样本)和不相似(负样本)的样本 。 传统方法 VS MoCo 端到端(End-to-end)方法(SimCLR,Inva Spread):将当前 mini-batch 内的样本作为字典 。这种方法的优点是字典中的键编码是一致的(由同一个编码器生成),但缺点是字典的大小受限于 mini-batch 的大小,而 mini-batch 大小又受限于 GPU 内存 。过大的 mini-batch 也会带来优化难题 。 Memory Bank...

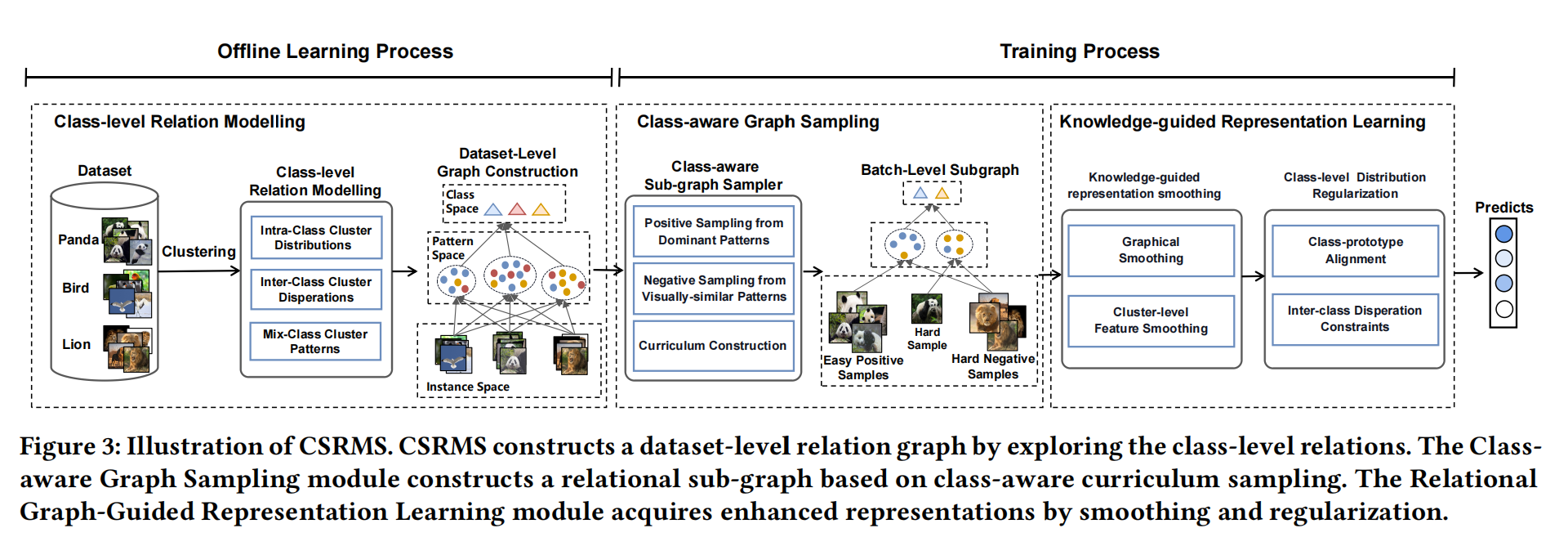

CSRMS

CSRMS 用于视觉表征学习的类级结构化关系建模与平滑 (MM2023) 论文地址:https://ercdm.sdu.edu.cn/__local/7/AC/70/7E4948C4761839F62E3958CE772_043AE854_2B459A.pdf 代码地址:https://github.com/czt117/CSRMS 个人理解这个像是一个知识总结的过程。首先通过特征提取获得特征图,这个过程可以类比我从书本上学习知识的过程,提取出有用的知识,然后通过聚类算法对特征图进行分簇,就相当于把学到的知识进行总结的过程,但是总会有一些比较相近的知识容易被搞混,这个就是类间相似性和类内多样性,再着重对这一块进行处理,使得对知识的掌握更加透彻。 名词解释: 课程构建(Curriculum...